Bessere A/B-Testvarianten dank UX-Research

Ergänzen Sie A/B Tests mit Nutzerforschung, um wahre Ursachen zu identifizieren und gut informierte Designvarianten zu entwickeln.

by Jennifer Cardello (deutsche Übersetzung) - 20.04.2014

A/B Splittests

A/B-Tests ermöglichen es, Varianten von Websites zu vergleichen, um festzustellen, welche Variante das beste Ergebnis liefert. Die Metriken, die in A/B-Tests verwendet werden, sind Mikro- und Makro-Konversionen. Seit es Tools gibt, die wenig bis gar keine technische Unterstützung benötigen, sind solche A/B-Tests an der Tagesordnung. Oft wird diese Form der Experimente von Marketing-Fachleuten verwendet. Sie erfährt aber inzwischen aufgrund ihrer relativ geringen Kosten auch bei UX-Designern grosse Beliebtheit. Websites wie Google, Amazon.com und viele grosse e-Commerce-Sites sind dafür bekannt, "ständig zu testen" - d.h. mit mehreren A/B-Tests, die zu jedem beliebigen Zeitpunkt ausgeführt werden.

Müll rein, Müll raus

A/B-Tests sind sehr wertvoll, wenn sie in angemessener Weise verwendet werden. Jedoch gibt es auch potenzielle Probleme mit A/B-Tests, die mit folgenden 3 Themen zu tun haben:

- Die Variante wird dem Konzept nicht gerecht. Ein armseliges Design kann zu armseligen Konversionen führen - das ist klar. Jedes Design jedoch stellt die Implementierung eines Konzepts dar und es ist dumm, die Verdienste eines Konzeptes nur durch eine einzige Design-Implementierung beurteilen zu wollen. Oft braucht man mehrere Design-Versuche (engl.), um einem Konzept gerecht zu werden. Zum Beispiel kann man vermuten, dass das Hinzufügen einer Beschreibung zu einer Option die Annahme dieser Option steigern wird. Wenn jedoch die Beschreibung so präsentiert wird, dass sie wie eine Werbung wirkt, wird sie ggf. von den Nutzern ignoriert. Das Konzept ist nicht schlecht, aber die Umsetzung ist es. Es ist wichtig, dass zwischen Konzept und Umsetzung deutlich unterschieden wird.

- Die Variante adressiert nicht die tatsächlichen Ursachen der Probleme. Inkorrekte Annahmen über die Ursache eines Problems führen zu Designvarianten, die das eigentliche Problem nicht lösen. Optimierungen dieser Variante werden nie das Problem lösen, weil sich das Design auf eine ungültige Annahme abstützt. Beispielsweise können Sie vermuten, dass der Grund dafür, dass ein Kreditangebot wenig genutzt wird, daran liegt, dass zu viele Bildschirme in den Prozess involviert sind, also reduzieren Sie auf einen Bildschirm, aber noch immer bewegt sich nichts. Das wirkliche Problem besteht aber darin, dass die Nutzer die Kreditzinsen nicht finden können, und der einzige Grund dafür, dass sie überhaupt auf der Antragsseite landen, ist, dass sie annehmen, sie würden diese dort finden.

- Varianten basieren auf Vermutungen. Mit A/B-Tests finden Sie nur die beste Option aus den verfügbaren Varianten. Und wenn die Varianten nur auf einem internen Erfahrungs- und Meinungsaustausch basieren, wer sagt, dass der Test überhaupt das optimale Design umfasst?

Diese Fehler können gemildert werden, indem man die Ergebnisse aus der Nutzerforschung in die A/B-Tests einbringt. Sogar, wenn nur eine minimale Nutzerforschung durchgeführt wird, gewinnen wir wertvolle Hinweise auf die möglichen Gründe für Probleme bei den Konversionen.

Wahre Ursachen aufdecken, um bessere Varianten zu definieren

"Eine Theorie kann durch das Experiment nachgewiesen werden; aber kein Weg führt vom Experiment zu der Geburt einer Theorie."

- Albert Einstein

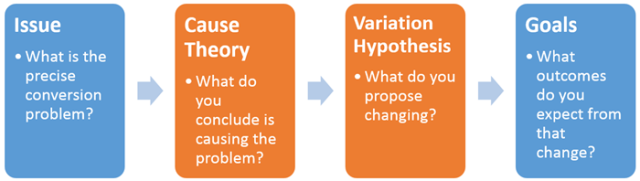

Um gut ausgeführte A/B-Tests zu gewährleisten, muss also für jedes Experiment Folgendes definiert werden:

Sie können alle Ihre Zeit damit verbringen, Theorien über die Ursachen und Hypothesen über Varianten aufzustellen und dann alle mit A/B-Tests zu prüfen: Das ist die Methode der sogenannten rohen Gewalt. Beliebige A/B-Tests sind das Äquivalent dazu, Ideen an die Wand zu werfen, um zu sehen, welche hängenbleiben. Unglücklicherweise können Sie sich das nicht leisten: Dieser Ansatz erhöht das Risiko, dass Ihre Nutzer Sie unterwegs verlassen, weil sie schlechte Erfahrungen machen.

Während Sie darauf warten, in der A/B-Test-Lotterie zu gewinnen, müssen Ihre Nutzer mit einem nicht optimalen Design interagieren. Ggf. werden sie beschliessen, dass Ihre Website ist ein hoffnungsloser Fall ist, und nie wieder kommen. Sie müssen die Anzahl an Hypothesen eingrenzen und A/B-Tests mit Vorsicht und effektiv einsetzen; wir empfehlen Ihnen die Nutzerforschung als Methode, die Ihnen dabei helfen kann.

Vier Untersuchungen der Nutzerforschung zur Verbesserung der Optimierungstests

- Absichten und Einwände der Nutzer definieren

Es ist wichtig, zu verstehen, warum die Nutzer die Umgebung besuchen, ob sie erfolgreich sind (oder glauben, dass sie es sind), und warum sie sich entscheiden, die Site zu verlassen. Wenn Sie inkorrekte Vermutungen darüber anstellen, warum Leute Ihre Seite besuchen, werden Ihre Ursachen-Theorien und Varianten-Hypothesen nicht die Umgebung widerspiegeln, wie sie von den Nutzern wahrgenommen wird. Es ist gefährlich, Einwände der Nutzer ohne Untersuchung zu übernehmen.

Beispielsweise, nehmen wir an, Sie gehen davon aus, dass Ihre Nutzer nicht die wünschenswerten Aktionen durchführen, weil Ihre Preise zu hoch sind. Also senken Sie Ihre Preise und Ihre Gewinnspanne wird beeinträchtigt. Wenn sich herausstellt, dass der wahre Grund, dass die Besuche nicht zu Konversionen geführt haben, nicht im Preis bestand, sondern darin, dass sie die Bedürfnisse der Nutzer, an die sich Ihr Service richtet, nicht richtig verstanden haben, haben Sie möglicherweise schon am Montag keinen Job mehr. - Wie man Absichten und Einwände definiert: Kurze Umfragen (engl.) beim Verlassen der Seite und/oder Follow-Up-Umfragen (via Tools wie Qualaroo (engl.)) die zwei einfache Fragen stellen:

- Warum haben Sie die Seite besucht?

- Waren Sie erfolgreich? Wenn nicht, warum nicht?

- Interface-Mängel aufdecken

Wenn Sie erhebliche Probleme mit der Nutzerfreundlichkeit übersehen, wie verwirrende Abläufe bei der Interaktion oder Hinweise missverstehen, dann sehen Sie nach den Optimierungen aus A/B-Tests möglicherweise nicht mehr Konversionen, weil Ihre Designvarianten nicht den Kern des Problems treffen. Beispiel: Wenn Sie ein Formular haben, wo mehrere der Felder nach Informationen fragen, die Ihre Nutzer nicht gerne hergeben möchten, ist es vergebliche Mühe, einen A/B-Test durchzuführen, um zu sehen, ob eine Änderung der Farbe des Absenden-Buttons zu einer Steigerung der Konversionen führt. Die wahren Ursachen für geringe Konversionsraten herauszufinden, ist entscheidend für die Durchführung intelligenter, erfolgreicher Versuche.

Wie man Mängel an der Oberfläche aufdeckt: Nutzerfreundlichkeits-Tests (Remote-moderiert, unmoderiert oder persönlich (engl.)) können schnell durchgeführt werden und können 85% der massiven Fehler in einer Website mit nur 5 Nutzern aufzudecken. - Auffindbarkeit messen

Experimente zur Beschriftung der Navigation und zum Design der Menüs weisen auf Probleme bei der Auffindbarkeit hin. Eine schlechte Auffindbarkeit kann und sollte bestätigt werden, bevor Sie A/B-Tests durchführen, die sich direkt auf die Informationsarchitektur und die Navigation auswirken. (Erfahren Sie mehr über Informationsarchitektur in unserem 2-Tages-Kurs.)

Wie man Auffindbarkeit misst: Tree-Tests messen die Auffindbarkeit von Elementen innerhalb einer bestehenden oder vorgeschlagenen Informationsarchitektur ohne jede Beeinflussung durch das Oberflächen-Design. Diese Tests können Ihnen sagen, ob Beschriftungen, Gruppierungen von Links, Hierarchien und die Nomenklatur intuitiv bedienbar sind. Wenn Sie sich bei der Bezeichnung der Abschnitte, Seiten, Links und Etiketten auf Ihrer Seite unsicher sind, kann dieser Test die problematischsten Benennungen identifizieren und Sie dabei unterstützen, neue Etiketten zu finden, die die Auffindbarkeit verbessern. Tree-Tests können mit einem Tool wie dem Treejack (engl.) von Optimal Workshop durchgeführt werden, der Ihnen ermöglicht, Aufgaben zu generieren, um eine Informationsarchitektur zu testen. - Designvarianten aufräumen, bevor sie live gehen

Die einfachste Anwendung von Nutzerfreundlichkeits-Tests ist es, ein Design zu bereinigen, indem man Stolpersteine für die Nutzer entfernt. Nur wenige Stunden zu testen, genügt in der Regel, um zu enthüllen, was an Ihrem Design wirklich schlecht ist. Während fortgeschrittene Formen der Nutzerforschung durchaus ihre Vorteile haben, übersehen Sie nicht die einfache Clean-Up-Studie. Für A/B-Tests wollen Sie sicherstellen, dass alle Designvarianten eine faire Chance bekommen, die nicht von Problemen mit der Nutzerfreundlichkeit beeinträchtigt werden, die die Kunden davon abhalten, die kompletten Vorteile jeder Variante zu nutzen. Also bereinigen Sie sie zuerst.

Methoden maximieren, um Konversionen zu maximieren

A/B-Tests sind ein wundervolles Werkzeug, das bedauerlicherweise schlecht eingesetzt werden kann. Wenn A/B-Tests anstelle von Studien eingesetzt werden, sind die Varianten im Wesentlichen nur Vermutungen. Sie können die Ergebnisse der A/B-Tests verbessern, indem Sie die UX-Forschung integrieren, um die Identifizierung von Ursachen zu verbessern, realistischere Annahmen zu entwickeln und mehr Möglichkeiten zum Experimentieren zu identifizieren.

Erfahren Sie mehr über A/B-Tests in unserem ganztägigen Kurs Analysen und Nutzererlebnisse.

© Deutsche Version. Institut für Software-Ergonomie und Usability AG. Alle Rechte vorbehalten.

Kommentare auf diesen Beitrag