Sprach-Interaktion UX: Schöne neue Welt…gleiche alte Geschichte

Obwohl sich die Sprachinterkation stark von grafischen Nutzeroberflächen abgrenzt, sind klassische Usability-Prinzipien dennoch für die Qualität des Nutzererlebnisses ausschlaggebend.

by Kathryn Whitenton (deutsche Übersetzung) - 31. Januar 2016

Die Verwendung der Sprachsteuerung zur Bedienung von Computern veränderte sich dank einer neuen Generation von Sprachinteraktionssystemen grundlegend. Siri von Apple und Google Now, die es inzwischen schon seit mehreren Jahren gibt beweisen, dass diese Technologie nicht mehr in den Kinderschuhen steckt. Inzwischen sind sie ein Kleinkind und beginnen, zu gehen und zu sprechen – fallen allerdings noch oft hin und sagen manchmal kompletten Blödsinn.

Echo: Weniger ist mehr?

Siri und Google Now sind in Smartphones integriert, doch Echo, ein neueres Sprachinteraktionssystem von Amazon, verfolgt einen anderen Ansatz und ermöglicht Sprachinteraktionen mit einem stationären Gerät, statt einem mobilen Betriebssystem.

Echo von Amazon, ein sprachgesteuerter Computer, ist wesentlich grösser als ein Handy (hier im Vergleich gezeigt). Der Echo muss immer mit einer Stromquelle verbunden sein.

Prinzipiell scheinen Siri, Google Now und Alexa (der Name, der im Gespräch mit Echo verwendet wird) relativ ähnlich zu sein. Sie alle warten auf „Aktivierungswörter“ und führen dann die Anweisungen der Nutzer aus – zum Beispiel spielen sie Musik, suchen nach Informationen und stellen Timer ein.

Interessant ist, dass der Echo mehrere Jahre vor Siri und Google Now auf den Markt kam – dennoch ist Alexa im Vergleich zu diesen Systemen nicht sehr klug. Hier sind die Antworten der drei Systeme auf dieselbe Frage:

Bei welcher Temperatur sollten Hühnchen gekocht werden?

Google Now: „Vierundsiebzig Grad Celsius, laut Kitchen Fact. Die sichere Kerntemperatur von gekochtem Hühnchen ist vierundsiebzig Grad Celsius.

Siri: „Lass mich nachsehen… Ok, ich habe im Internet Informationen darüber gefunden, bei welcher Temperatur Hühnchen gekocht werden sollte… sieh sie dir an.“

Alexa: Es tut mir leid, ich habe die gehörte Frage nicht verstanden.

Alexa ist ganz klar nicht die Cleverste. Ihr fehlt auch etwas, über das sowohl Siri als auch Google Now verfügen: ein Bildschirm für visuelle Darstellungen. Der Echo verfügt über eine begleitende Smartphone-App, über die allerdings hauptsächlich Einstellungen geändert und Hilfsfunktionen genutzt werden können. Die Hauptinteraktion findet mit dem Gerät statt, das im Prinzip ein Computer ist, der immer in die Steckdose eingesteckt sein muss und nur über Lautsprecher und Mikrofon verfügt. Ohne Bildschirm kann der Echo keine praktischen Ausgaben, wie Listen mit Suchresultaten, anzeigen.

Es scheint, als wäre der Echo ein grosser Rückschritt – vor allem, wenn man bedenkt, dass die meisten Technologiefans Early Adopters neuer Produkte sind, und wahrscheinlich bereits ein Smartphone mit Siri oder Google Now besitzen.

Warum sollten Menschen also für ein Gerät bezahlen, das weniger kann, als das Gerät, das sie bereits besitzen?

Fehlervermeidung

Eine der klassischen Usability-Heuristiken ist die Fehlervermeidung: die Idee, dass Systeme Nutzern nicht nur bei der Fehlerbehebung helfen sollten, sondern verhindern sollten, dass Fehler überhaupt auftreten. Da die Spracherkennung in den letzten Jahren verbessert wurde, reduzierten sich die Fehler beim Verstehen der natürlichen Sprache signifikant. Dieser Trend wird sich hoffentlich über alle Sprachinteraktionssysteme hinweg fortsetzen.

Es gibt allerdings einen Fehlertyp, der bei der Smartphone-basierten Sprachinteraktion relativ häufig auftritt: die Unfähigkeit, das Aktivierungswort zu erkennen. Dieses Problem tritt besonders häufig auf, wenn es in der Umgebung mehrere Geräuschquellen gibt – wenn das Gerät zum Beispiel Musik abspielt und Sie den Befehl geben, die Musik auszuschalten. Dieser Fall wird im nachfolgenden Video gezeigt:

Ein entsprechendes Video sehen Sie hier: https://media.nngroup.com/media/editor/2016/01/11/Alexa-vs-Siri-Play-the-Beatles.mp4

Wie im Video gezeigt, erkennt Siri Sprachbefehle oft nicht, wenn es störende Geräusche, wie Musik, wahrnimmt. Siri kann Befehle auch ignorieren, wenn das Gerät relativ weit entfernt ist oder wenn es sich in der Hosentasche oder einer Handtasche befindet. Falls Sie einen Timer eingestellt haben und wissen möchten, wie viel Zeit noch bleibt, sieht ein typisches Gespräch mit Siri wie folgt aus (die Frage wurde auf Englisch gestellt):

Hey Siri, wie viel Zeit bleibt noch? („Hey Siri, how much time is left?“) (mit dem Handy in der Tasche.)

Siri:

Hey Siri, wie viel Zeit bleibt noch? (nachdem das Handy aus der Tasche genommen wurde)

Siri: Ich habe einen Artikel über die Times gefunden. Soll ich ihn Ihnen vorlesen?

Nein, wie viel Zeit bleibt noch am Timer?

Siri: Hier ist der Timer. Er läuft seit 8 Minuten und 8 Sekunden.

Echo verleiht hingegen der Sprachinteraktion die höchste Priorität. Er enthält 7 Mikrofone und konzentriert sich vor allem darauf, Sprachbefehle von Hintergrundgeräuschen zu unterscheiden (im Gegensatz zum iPhone 6s, das ein kompaktes mobiles Gerät mit einem Bildschirm und nur 2 Mikrofonen ist). Die Resultate sind unglaublich. Sie müssen das Gerät auch nicht aus der Tasche nehmen – selbst von der anderen Seite des Raums antwortet Alexa verlässlich:

Alexa, wie viel Zeit bleibt noch?

Alexa: Rund 6 Minuten und 10 Sekunden.

Neben der besseren Stimmerkennung gibt es auch Unterschiede bei der semantischen Verarbeitung der beiden oben beschriebenen Beispiele: Alexa interpretierte „Time“ („Zeit“) als Bezugnahme auf den Timer des Geräts, während Siri annahm, dass es sich um eine generelle Suchanfrage handelte, die es erst dann mit dem Timer in Verbindung brachte, als das spezifische Keyword „Timer“ genannt wurde. Siris Fähigkeit, Internetsuchen durch Sprachbefehle zu beschleunigen, ist sicherlich wertvoll – dass Nutzerfragen allerdings tendenziell als Suchanfragen interpretiert werden, kann die Fehlerquote bei anderen Aufgaben aber erhöhen. Die Vorteile der zielgerichteten Funktionen des Echo sind noch offensichtlicher, wenn Sie mehrere Timer benötigen (was beim Kochen nicht so ungewöhnlich ist). Wenn Sie darum bitten, einen neuen Timer zu starten, antwortet Alexa: „Zweiter Timer auf 40 Minuten eingestellt, startet jetzt“, während Siri, die nur über einen Timer verfügt, Ihre Pläne vereitelt: „Ihr Timer läuft bereits, derzeit bei 9 Minuten und 42 Sekunden. Möchten Sie ihn ändern?“

Siris weniger effektive Spracherkennung ist nicht immer ein Problem – es hängt von der Aufgabe ab. Bei der Suche nach Informationen muss man sich normalerweise ohnehin direkt vor einem Bildschirm befinden, um die Resultate zu sehen – das Handy aus der Tasche zu holen, macht die Aufgabe nicht zeitaufwändiger, als sie es ohne Sprachsteuerung gewesen wäre. Das Aussprechen des Befehls geht aber schneller, als ihn einzugeben.

Bei kurzen Aufgaben kann sich dieses Verhältnis aber schnell ändern, falls der Befehl beim ersten Versuch nicht verstanden wird. Dadurch wird das Sprachsystem umständlicher und zeitraubender als eine vorhandene physische Alternative, zum Beispiel ein Blick auf einen digitalen Timer oder das Durchqueren eines Raums, um den Lichtschalter zu betätigen. Neue Technologien müssen Aufgaben schneller und einfacher erledigen, um als angemessener Ersatz für vorhandene Instrumente zu gelten. Fehler in der Spracherkennung können das bei kurzen Aufgaben unmöglich machen.

Flexibilität und Effizienz

Alexas Präzision beim Erkennen von Sprachbefehlen aus grosser Distanz und trotz Hintergrundgeräuschen beeinflusst ein weiteres wichtiges Usability-Prinzip: die Flexibilität und Effizienz des Systems.

Sprachinteraktionssysteme für Smartphones können Sie überall hin mitnehmen, während der Echo grösser ist und eine Stromquelle benötigt, weshalb man ihn nur zu Hause verwenden kann. Paradoxerweise ist das vergleichsweise unhandliche Gerät in dieser Umgebung wesentlich flexibler, das es Nutzer nicht ständig mit sich herumtragen müssen, um auf seine Funktionen zugreifen zu können. So stehen Ihnen mehr Möglichkeiten zur Verwendung des Geräts zur Verfügung: Sie können mit ihm sprechen, während Sie gerade etwas anderen zum – zum Beispiel kochen – oder es vom Bett oder der Couch aus verwenden, falls Ihr Bewegungsradius aufgrund einer Behinderung eingeschränkt ist oder Sie einfach nicht aufstehen wollen.

Diese Art der reinen Sprachsteuerung setzt die ständige Suche nach einem Aktivierungswort voraus. Obwohl es seltsam erscheinen mag, dass jedes Wort von einem Gerät registriert wird, ist das Spracherkennungsgerät in Wirklichkeit weniger aufdringlich – da Sie sich nicht daran erinnern müssen, es mitzunehmen, und es nicht aus der Tasche holen und ansehen müssen.

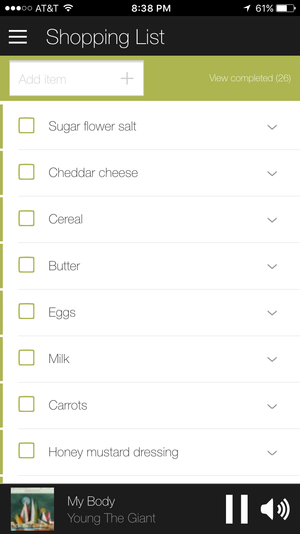

Andererseits ist eine der grössten Einschränkungen des Echo, dass bestimmte Aufgaben extrem ineffizient sind. Einem Einkaufszettel ein Produkt hinzuzufügen, geht einfach und schnell – das Hinzufügen mehrerer Produkte ist allerdings eine repetitive, zeitraubende Aufgabe. Für jedes Produkt müssen Aktivierungswort und Befehl genannt werden, wonach der Nutzer auf eine verbale Bestätigung warten muss – danach muss der Vorgang für das nächste Produkt wiederholt werden. Das Resultat ist ein derartiges Gespräch:

Nutzer: Alexa, schreib Milch auf den Einkaufszettel.

Alexa: Ich habe Milch auf den Einkaufszettel geschrieben.

Nutzer: Alexa, schreib Eier auf den Einkaufszettel.

Alexa: Ich habe Eier auf den Einkaufszettel geschrieben.

Nutzer: Alexa, schreib Butter auf den Einkaufszettel.

Alexa: Ich habe Butter auf den Einkaufszettel geschrieben.

Nutzer: Alexa, schreib Müsli auf den Einkaufszettel.

Alexa: Ich habe Müsli auf den Einkaufszettel geschrieben.

Nutzer: Alexa, schreib Cheddar-Käse auf den Einkaufszettel.

Alexa: Ich habe Cheddar-Käse auf den Einkaufszettel geschrieben.

Nutzer: Alexa, schreib Zucker, Mehl und Salz auf den Einkaufszettel.

Alexa: Ich habe Zucker Mehl Salz auf den Einkaufszettel geschrieben.

Nach dem dritten Produkt überlegt man, dass es doch eine schnellere Methode geben muss. Sie können den Ablauf verkürzen, indem Sie mehrere Produkte nacheinander nennen, in der Liste werden diese Produkte allerdings, wie Sie unten stehen können, alle im selben Punkt angeführt.

Wenn Sie Alexa bitten, „Zucker, Mehr und Salz“ auf den Einkaufszettel zu schreiben, fügt sie ein Produkt „Zucker Mehl Salz“ hinzu. Obwohl das ausreichen könnte, um Ihrem Gedächtnis im Supermarkt auf die Sprünge zu helfen, ist es sicherlich nicht die Absicht des Befehls.

Schlussfolgerung

Andere Aspekte von Alexa liefern schlechtere Resultate als Siri oder Google Now, was die Einhaltung von Usability-Heuristiken betrifft. Der Grund dafür ist vor allem das Fehlen eines Bildschirms:

- Die Sichtbarkeit des Systemstatus ist auf den animierten Lichtstreifen beschränkt. Dieser funktioniert zwar gut, kann aber nicht mit dem umfangreichen Text-Feedback eines Bildschirms mithalten.

- Identifikation statt Erinnerung ist in einer Nutzeroberfläche, die nur über eine Sprachausgabe verfügt, ebenfalls nur eingeschränkt möglich, da selbst das einfache Vorlesen einer Liste von Möglichkeiten voraussetzt, dass Nutzer die genannten Optionen im Arbeitsgedächtnis behalten, während sie eine Auswahl treffen.

Wenn neue Technologien auf den Markt kommen, verkünden Enthusiasten meist schnell, dass wir jetzt von vorne beginnen und Designmethoden bzw. Prinzipien entwickeln müssen, die besser zur neuen Technologie passen. Die visuelle Anzeige zu eliminieren, verändert das Interaktionserlebnis definitiv grundlegend. Doch bedeutet der Wechsel vom visuellen zum akustischen Output, dass sich alle Regeln geändert haben?

Egal, wie unterschiedlich die Technologie ist: die Menschen, die sie verwenden, haben sich nicht verändert. Die meisten Usability-Prinzipien zielen stärker auf menschliche Fähigkeiten und Einschränkungen ab, als auf Technologien. (Beispiele für die im Artikel erwähnten immerwährenden Designprinzipien sind Fehlervermeidung, Flexibilität, Effizienz, Sichtbarkeit des Systemstatus und Identifikation vs. Erinnerung.) Der Echo bietet selbst Nutzern, die bereits über gute Sprachinteraktionssysteme verfügen, einzigartige Vorteile. Obwohl das Stimmmedium ganz anders ist, können sowohl die frustrierenden Fehler als auch die scheinbar magischen Erfolgsmomente bei der Nutzung des Echo ganz klar etablierten Usability-Heuristiken zugeordnet werden.

© Deutsche Version. Institut für Software-Ergonomie und Usability AG. Alle Rechte vorbehalten.

Kommentare auf diesen Beitrag